高斯—牛顿叠代法

高斯一牛顿叠代法(Gauss-Newton iteration method)是非线性回归模型中求回归参数进行最小二乘的一种叠代方法,该法使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次叠代,多次修正回归係数,使回归係数不断逼近非线性回归模型的最佳回归係数,最后使原模型的残差平方和达到最小。其直观思想是先选取一个参数向量的参数值β,若函式ft(Xt,β)在β0附近有连续二阶偏导数,则在β0的邻域内可近似地将ft(Xt,β)看作是线性,因而可近似地用线性最小二乘法求解。

基本介绍

- 中文名:高斯—牛顿叠代法

- 外文名:Gauss-Newton iteration method

- 别称:高斯—牛顿法、泰勒级数展开法

- 所属学科:数学

- 相关概念:泰勒级数展开式,残差平方和等

基本思想

高斯-牛顿叠代法的基本思想是,使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次叠代,多次修正回归係数,使回归係数不断通过通近非线性回归模型的最佳回归係数,最后使原模型的残差平方和达到最小。

一般步骤

高斯-牛顿法的一般步骤如下所示。

(1) 初始值的选择。其方法有三种:

一是根据以往的经验选定初始值;

二是用分段法求出初始值;

三是对于可线性化的非线性回归模型,通过线性变换,然后施行最小平方法求出初始值。

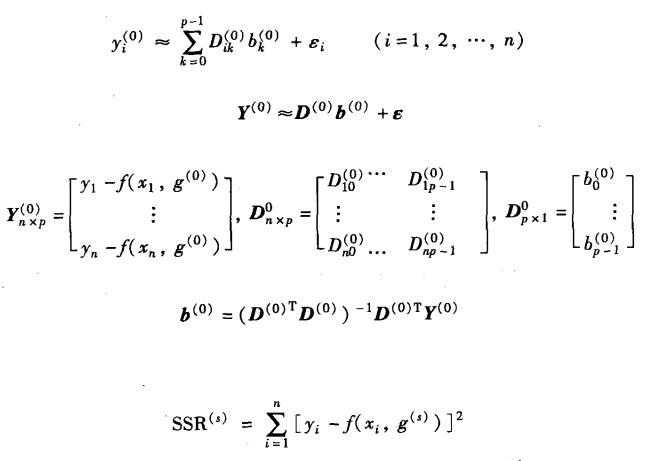

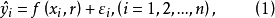

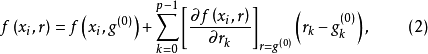

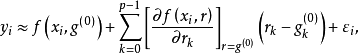

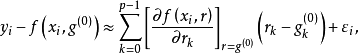

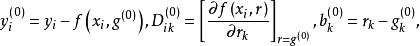

(2)泰勒级数展开式。设非线性回归模型为

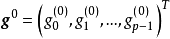

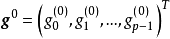

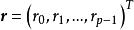

设 为待估回归係数

为待估回归係数 的初始值,将式(1)

的初始值,将式(1) 在g点附近作泰勒展开,并略去非线性回归模型的二阶及二阶以上的偏导数项,得

在g点附近作泰勒展开,并略去非线性回归模型的二阶及二阶以上的偏导数项,得

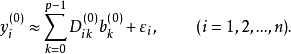

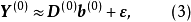

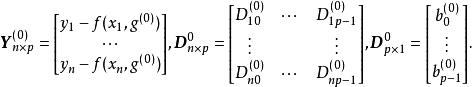

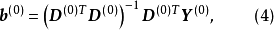

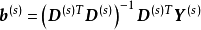

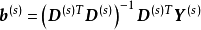

(3)估计修正因子。用最小平方法对式(3)估计修正

则

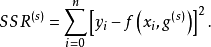

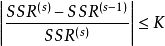

(4)精确度的检验。设残差平方和为

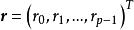

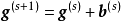

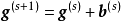

(5)重複叠代。重複式(4),当重複叠代s次吋,则有

修正因子 ,第(s+1)次叠代值

,第(s+1)次叠代值 。

。

海之美文新闻资讯

海之美文新闻资讯